CodeQwen 오픈소스 AI모델과 VSCode Continue 익스텐션을

개발에 활용하는 방법에 대한 새 글을 업로드했습니다."

- 2024. 5. 25. -

VSCode Github Copilot을 대체할 수 있는 무료 로컬 LLM 및 Groq Llama 70b

EvalPlus LeaderboardEvalPlus는 AI 코더를 평가하는 엄격한 테스트를 통해 벤치마크를 제공합니다. 순위표를 살펴보면 GPT-4 다음으로 CodeQwen1.5-7B-Chat 모델의 점수가 가장 높습니다. 그리고 CodeQwen1.5-7B-Chat

anpigon.tistory.com

Ollma는 무료로 사용할 수 있는 로컬 AI 도구로, 이전 글 "로컬에서 무료로 사용할 수 있는 LLM 도구, Ollama 활용 가이드"에서 Ollama의 설치 방법을 소개한 바 있습니다. 이번 글에서는 Ollma와 Codellama를 VSCode에서 사용하는 방법을 상세히 설명하겠습니다.

Ollama 설치 방법

MacOS와 Linux 사용자는 Ollama 공식 웹사이트에서 프로그램을 다운로드할 수 있습니다. MacOS 사용자는 Homebrew를 통해 쉽게 설치 가능합니다.

MacOS & Homebrew

MacOS에서는 Homebrew를 통해 쉽게 설치가 가능합니다.

brew install ollama

# CLI 만 사용하고 싶다면 아래의 명령어를 실행하세요

brew install ollama --formulaeWindows

Windows 버전은 출시될 예정입니다. 현재는 WSL2를 통해 설치할 수 있습니다.

Linux & WSL2

curl https://ollama.ai/install.sh | sh수동 설치 가이드를 참조하면 더 자세한 설치 방법을 알 수 있습니다.

Docker

Ollama의 공식 Ollama Docker 이미지 는 Docker Hub에서 사용할 수 있습니다.

Ollama에서 지원하는 AI 모델 라이브러리

Ollama는 다양한 오픈 소스 AI 모델을 지원합니다. ollama.ai/library에서 확인할 수 있으며, 일부 모델의 예시는 다음과 같습니다:

| Model | Parameters | Size | Download |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Dolphin Phi | 2.7B | 1.6GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1.7GB | ollama run phi |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1.9GB | ollama run orca-mini |

| Vicuna | 7B | 3.8GB | ollama run vicuna |

| LLaVA | 7B | 4.5GB | ollama run llava |

참고: 7B 모델을 실행하려면 최소 8GB, 13B 모델을 실행하려면 16GB, 33B 모델을 실행하려면 32GB의 RAM이 필요합니다.

Code Llama: 코드 생성 및 토론을 위한 모델

Code Llama는 프롬프트를 사용하여 코드를 생성하고 토론하는 모델입니다. Ollama에서 Codellama 모델을 다운로드하는 방법은 다음과 같습니다:

ollama pull codellama:34b

Codellama는 다양한 파라미터 크기로 제공되며, 사용자의 요구에 맞게 선택할 수 있습니다. 파라미터의 양이 적을수록 메모리 사용량이 줄어들지만, 반대로 정확도는 약간 떨어질 수 있습니다.

Parameter counts

| Parameter Count | Recommended memory | ||

|---|---|---|---|

| 7 billion | 8GB | View | ollama run codellama:7b |

| 13 billion | 16GB | View | ollama run codellama:13b |

| 34 billion | 32GB | View | ollama run codellama:34b |

Codellama의 Variations

Codellama는 세 가지 Variations 모델을 제공합니다:

instruct: 자연어로 답변을 생성하는 데 튜닝된 모델python: Python 코드에 특화된 모델code: 코드 완성을 위한 기본 모델

Code Llama에 프롬프트하는 방법은 Ollama의 공식 문서에서 확인할 수 있습니다.

Code Llama는 Cody 서비스에서 실험적으로 사용되고 있으며, Cody 일반 버전은 무료로 사용할 수 있습니다. Cody Pro 버전은 2024년 2월까지 무료로 사용 가능합니다.

VSCode와 Continue를 이용한 Ollama 연동

Continue는 개발자를 위한 오픈소스 코파일럿으로서, VS Code와 JetBrains에서 사용 가능합니다.

Continue 플러그인을 설치하면 VSCode의 사이드바에 Continue 아이콘이 생성됩니다. 이 아이콘을 클릭하고 톱니바퀴 아이콘을 통해 config.json 파일을 열어 다음 설정을 추가하세요. model에는 본인이 사용하는 모델명을 입력합니다.

{

"title": "CodeLlama:34b",

"provider": "ollama",

"model": "codellama:34b"

}

[설정 예시 화면]

단축키 Cmd + Shift + L을 이용해 ‘generate code’ 기능을 실행할 수 있습니다. 이를 통해 특정 함수, 예를 들면 피보나치를 계산하는 함수를 작성하도록 요청할 수 있습니다.

잠시 기다리면 코드가 자동으로 작성되는 과정을 볼 수 있습니다.

조금 더 복잡한 함수, 예를 들어 Yahoo Finance에서 Bitcoin의 현재 가격을 조회하는 함수를 작성하는 요청도 해볼 수 있습니다.

Write a function to get the current price of Bitcoin on Yahoo Finance.

아래와 같이 코드가 작성됩니다.

실행 결과, yfinance 패키지 관련 오류가 발생했지만, 코드 작성 과정은 간편하고 유용합니다.

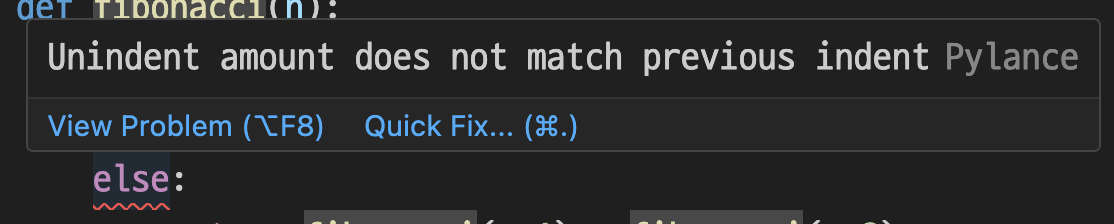

AI를 활용한 코드 문제 해결

코드에 문제가 발생했을 때는, 문제가 있는 코드 부분 위에 마우스를 올려 'Quick Fix…'를 클릭하거나,

단축키 Cmd + .을 사용하여 문제를 해결할 수 있습니다.

팝업 메뉴에서 'Ask Continue’를 선택하면, AI가 문제 해결 방법을 제시합니다.

아래와 같이 Continue 채팅창에 해당 문제에 대한 진단 결과와 해결방법이 출력됩니다.

선택한 코드에 대해서 추가 요청하기

코드를 선택한 후, ‘Continue > Add Highlighted Code to Context’ 메뉴를 클릭하거나 Cmd + Shift + M 단축키를 사용해 코드를 Continue 채팅창에 추가할 수 있습니다.

이후 해당 코드에 대한 질문이나 추가 요청을 할 수 있습니다.

마치며

이 가이드는 개발자들이 Continue 플러그인을 효율적으로 사용하는 데 도움이 될 것입니다. VSCode나 JetBrains 환경에서 AI 더 많이 활용하여 개발 작업을 간소화하고, 문제 해결 과정을 빠르게 진행할 수 있습니다.

'생산성 > 개발 생산성 업그레이드' 카테고리의 다른 글

| OpenCommit을 이용해 Git 커밋 자동화 및 무료 로컬 LLM 연동 방법 (1) | 2024.05.29 |

|---|---|

| ShellGPT: 터미널에서 사용하는 강력한 AI 도구, Github Copilot CLI의 대체제 (1) | 2024.05.28 |

| VSCode Github Copilot을 대체할 수 있는 무료 로컬AI Qwen 및 Groq Llama 70b (5) | 2024.05.26 |

| GPT-3 도움으로 커밋 메시지를 자동으로 작성해보자. (0) | 2023.04.07 |