이번 가이드에서는 Ollama 웹 UI를 활용하는 방법에 대해 상세하게 안내해 드립니다. 이 글은 PC와 모바일에서 Ollama를 이용하는 방법부터 크롬 익스텐션을 통한 사용 방법까지 다양한 경로를 제공합니다. 사용자의 환경과 필요에 따라 선택하여 사용할 수 있습니다.

Ollama란 무엇인가?

Ollama는 로컬에서 대형 언어 모델(LLM)을 쉽게 사용할 수 있도록 지원하는 플랫폼입니다. macOS, Windows, Linux에서 간편하게 설치할 수 있으며, Docker를 지원하여 더욱 다양한 환경에서 활용 가능합니다. Ollama는 ollama run llama3와 같은 간단한 명령어로 빠르게 AI 모델과 상호작용할 수 있습니다. Llama3, Phi3, Wizardlm2, Gemma, CodeGemma, LLaVa 등의 다양한 오픈 소스 모델을 지원하며, 사용자는 이들 중 필요한 모델을 선택하여 사용할 수 있습니다. 자세한 내용은 Ollama 공식 웹사이트에서 확인하실 수 있습니다.

Ollama 설치 방법

- Ollama 홈페이지에서 직접 다운로드하여 설치합니다.

- 맥 사용자는 homebrew를 통해 다음과 같이 간편하게 설치할 수 있습니다.

brew install ollama 더 다양한 설치 방법이나 사용 방법은 Ollama의 Github 페이지에서 확인할 수 있습니다.

Ollama에서 모델 선택 및 실행 방법

Ollama는 llama3, phi3, codellama 등의 인기 있는 AI 모델을 제공합니다. llama3는 8b, 70b 모델을 지원하며, 각각 실행하기 위해 8GB, 64GB RAM이 필요합니다. 다양한 AI 모델을 Ollama 라이브러리 페이지에서 확인할 수 있습니다.

아래 명령어를 통해 원하는 모델을 실행할 수 있습니다:

# Meta에서 출시한 현재 가장 인기 있는 AI모델

ollama run llama3

# 코드 생성을 위한 AI모델

ollama run codellama

# 멀티모달 AI모델

ollama run llava위와 같은 명령어를 입력하면, 해당 모델은 자동으로 다운로드되고 실행됩니다.

Ollama 활용 예시

Ollama를 통해 매우 간편하게 LLM에 질문하고 답변을 받을 수 있습니다.

예를 들어, "세종대왕님 맥북 던짐 사건"에 대한 질문을 Mistral 모델로 실행하면, 다음과 같은 결과를 얻을 수 있습니다.

위 예시는 Ollama를 통해 LLM에 질문하고 답변을 받는 과정을 보여줍니다. 그러나 Ollama의 답변 품질이 GPT 4 Turbo에 비해 다소 떨어질 수 있다는 점을 고려하여 사용해야 합니다.

"세종대왕님 맥북 던짐 사건"에 관련된 기사는 아래에서 확인할 수 있습니다:

- 클리앙 - 세종대왕의 맥북프로 던짐 사건

- 조선일보 - “세종대왕의 맥북 던짐 사건에 대해 알려줘” 했더니 챗GPT가 내놓은 답변은?

- 한국일보 - “세종대왕 맥북 던짐 사건 알려줘” 물었더니… 챗GPT의 엉뚱 답변 '밈’으로 유행 중

Ollama는 AI 모델을 로컬에서 사용하고자 하는 사용자에게 유용하며, 다양한 모델을 쉽게 다운로드하여 사용할 수 있는 장점이 있습니다. 그러나 사용자의 장비 사양에 따라 모델 선택에 제한이 있을 수 있으니 이점 주의해야 합니다.

Ollama 웹UI 사용 가이드

Ollama 웹UI의 사용 방법은 다음과 같습니다:

1. Ollama 서버 실행

먼저, 아래의 명령어를 사용하여 Ollama 서버를 실행합니다.

OLLAMA_ORIGINS=* ollama serve

2. chatbot-ollama 코드 다운로드 및 패키지 설치

이후, chatbot-ollama 코드를 다운로드하고 필요한 패키지를 설치합니다.

git clone git@github.com:ivanfioravanti/chatbot-ollama.git

cd chatbot-ollama

npm install오픈소스 중에서 open-webui가 가장 인기가 많고 기능이 강력하지만 설치하는 방법이 복잡합니다.

그러나 chatbot-ollama는 설치 방법이 비교적 쉽습니다. 강력한 기능을 원한다면 open-webui를 추천합니다.

3. chatbot-ollama 웹서버 실행

마지막으로, chatbot-ollama 웹서버를 실행합니다.

npm run dev

4. Ollama 웹UI 접속

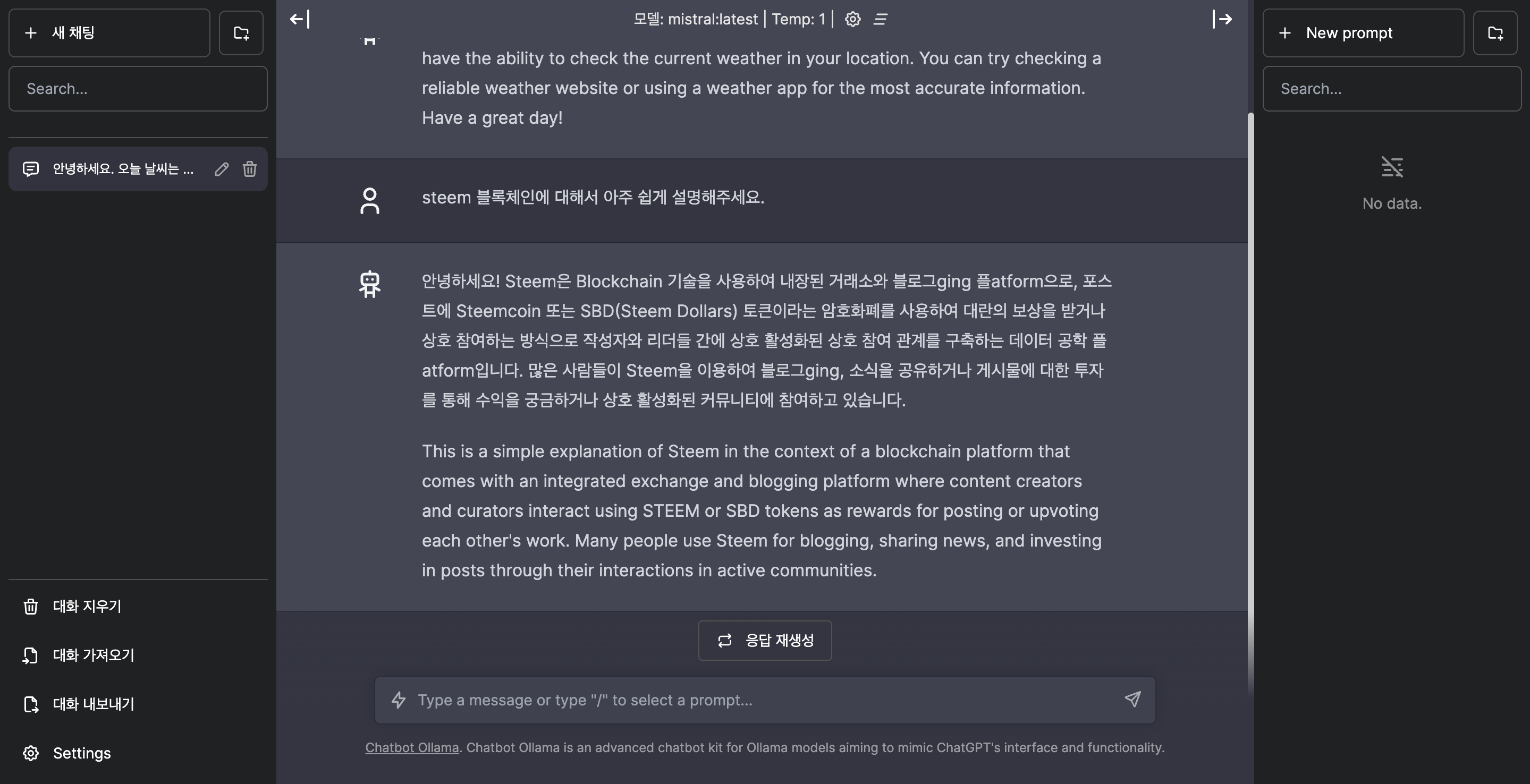

웹서버를 실행한 후, 웹브라우저 주소창에 http://localhost:3000를 입력하면 Ollama 웹 UI에 접속할 수 있습니다. 아래는 웹 UI의 초기 화면 및 채팅 화면입니다.

Ollama 웹UI 크롬 익스텐션 사용하기

앞에서 설명한 Ollama 웹 UI를 사용하는 방법이 번거롭다면, 크롬 익스텐션을 통해 더 쉬운 접근이 가능합니다. 여기에서 “ollama-ui” 크롬 익스텐션을 다운로드하면 웹브라우저에서 쉽게 Ollama를 활용하실 수 있습니다.

Ollama 모바일앱 사용 가이드

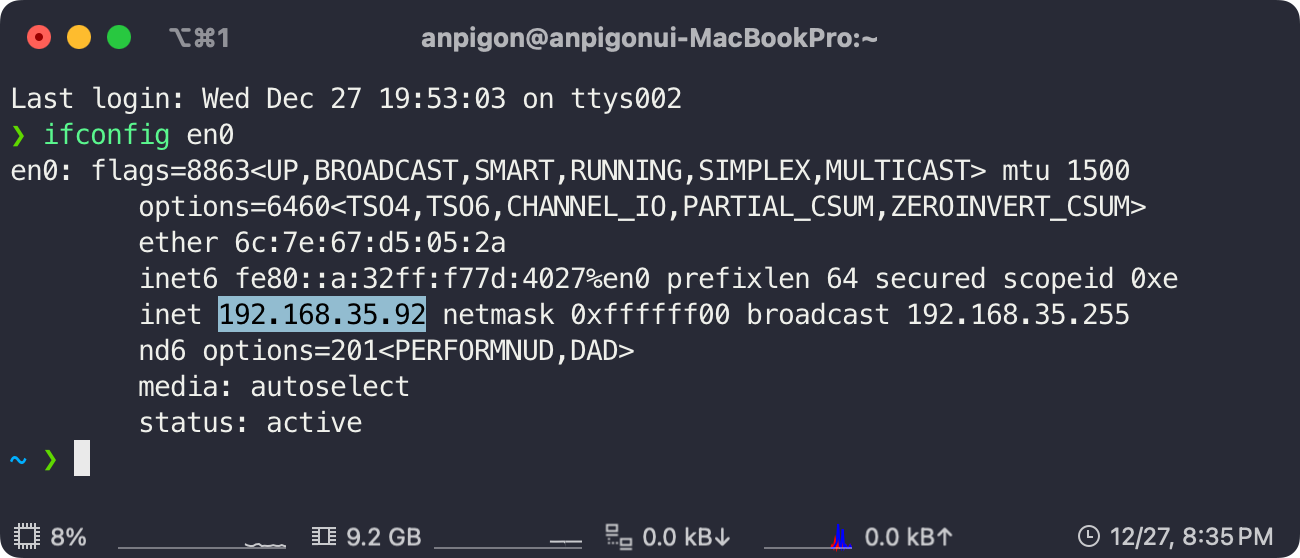

모바일에서 Ollama를 사용하는 방법은 다음과 같습니다. 모바일앱에서 내 PC에서 실행중인 Ollama에 접속하기 위해서는 내 PC의 IP주소를 알아야 합니다.

1. PC의 로컬 IP 확인

먼저, 내 PC의 로컬 IP를 확인합니다.

2. Ollama 서버 재시작

만약 macOS를 사용 중이라면, 다음과 같이 launchctl setenv 명령어를 사용하여, 아래의 환경변수를 설정하여 IP 주소를 설정할 수 있습니다. OLLAMA_HOST에는 내 컴퓨터의 로컬 IP 주소를 입력합니다.

launchctl setenv OLLAMA_HOST "192.168.35.92:11434"리눅스 사용자의 경우에는 Ollama FAQ 링크를 참고하여 Ollama 서버를 구성할 수 있습니다.

그 후에는 Ollama 앱을 종료하고 다시 실행합니다.

또한, 아래와 같은 명령어를 사용하여 Ollama 서버를 시작할 수도 있습니다:

OLLAMA_HOST=192.168.35.92:11434 ollama serve ngrok 서비스를 이용하면 외부에서 접속 가능하게 설정할 수도 있습니다.

3. 모바일 앱 설치 및 실행

모바일에서는 아래의 앱을 설치하여 사용하실 수 있습니다.

- iOS: Enchanted LLM

- Android: Amallo for Ollama

모바일과 PC를 동일한 네트워크에 연결한 후, Ollama 모바일 앱을 실행하고 Ollama 서버 IP를 입력하여 사용합니다.

모바일 앱에서 Mistral 모델을 사용하여 대화를 합니다.

기타 다른 모바일용 무료 LLM 앱 소개

아래에서 소개하는 앱들은 모두 iOS, Android, macOS, 그리고 Windows 환경에서 사용 가능합니다.

결론

Ollama는 사용자가 로컬 환경에서 다양한 AI 언어 모델을 쉽게 이용할 수 있게 하는 도구입니다. 이 가이드는 설치부터 실행, 웹 UI와 모바일 앱 사용까지 전 과정을 상세히 설명합니다. 사용 환경에 맞춰 편리하게 Ollama를 활용하시기 바랍니다.

or

'생산성 > ChatGPT 활용하기' 카테고리의 다른 글

| AI가 유튜브 영상을 요약해준다? 릴리스AI와 써머리로 시간 단축하고 지식 쌓기! (0) | 2024.01.11 |

|---|---|

| 순식간에 PPT를 생성해주는 AI 서비스 - Gamma (0) | 2023.04.16 |

| ChatGPT를 사용하여 순식간에 차트 만드는 방법 (1) | 2023.04.12 |

| 스팀잇 블록체인에 GPT-3를 연동하다 (0) | 2023.04.08 |

| ChatGPT를 활용하여 블로그 글을 작성하는 방법 by David Sacks (0) | 2023.04.06 |