Logseq 사용자들을 위한 강력하고 무료인 AI 도구, Ollama와 Logseq-Ollama 플러그인 대해 자세히 알아보겠습니다. Ollama는 로컬 환경에서의 AI 작업을 간소화하고 효율성을 극대화하는 도구입니다. 이 가이드를 통해 Ollama의 설치부터 사용 방법까지 쉽게 이해할 수 있도록 도와드리겠습니다.

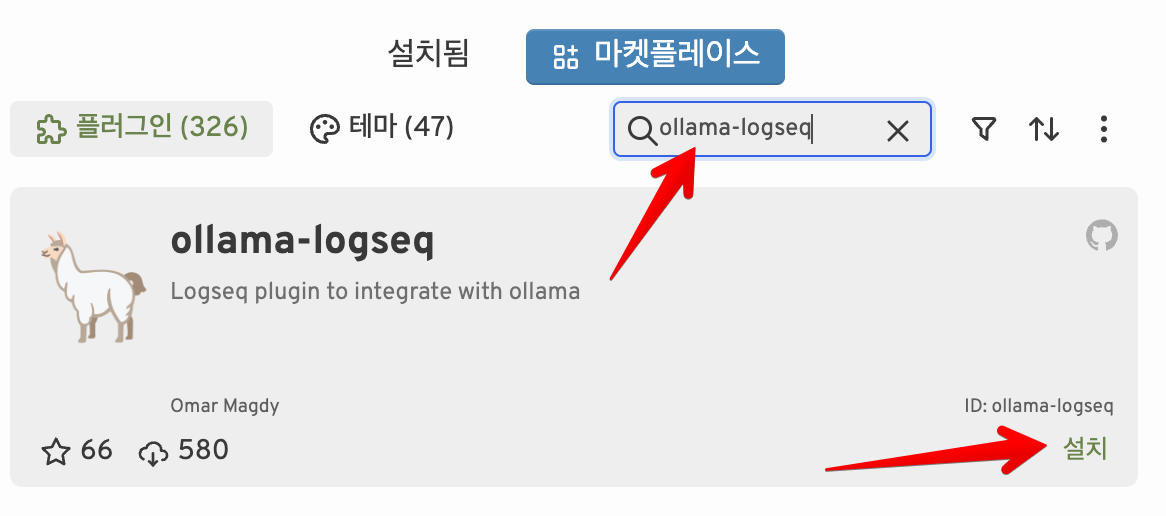

Logseq Ollama 플러그인 설치 및 기본 설정

Logseq에서 Ollama를 사용하기 위해 첫 번째 단계는 플러그인의 설치입니다. Logseq 마켓플레이스에서 'ollama-logseq’를 검색하여 설치할 수 있습니다.

설치 후, ‘ollama-logseq’ 플러그인 설정에 들어가 LLM Model을 mistral:latest로 변경합니다.

올라마 AI 모델 설정 및 사용

Ollama는 “로컬에서 무료로 사용할 수 있는 LLM 도구, Ollama 활용 가이드” 글에서 자세하게 다루고 있습니다. Ollama 설치 방법이나 자세한 사용 방법은 이 글을 참고하시기 바랍니다.

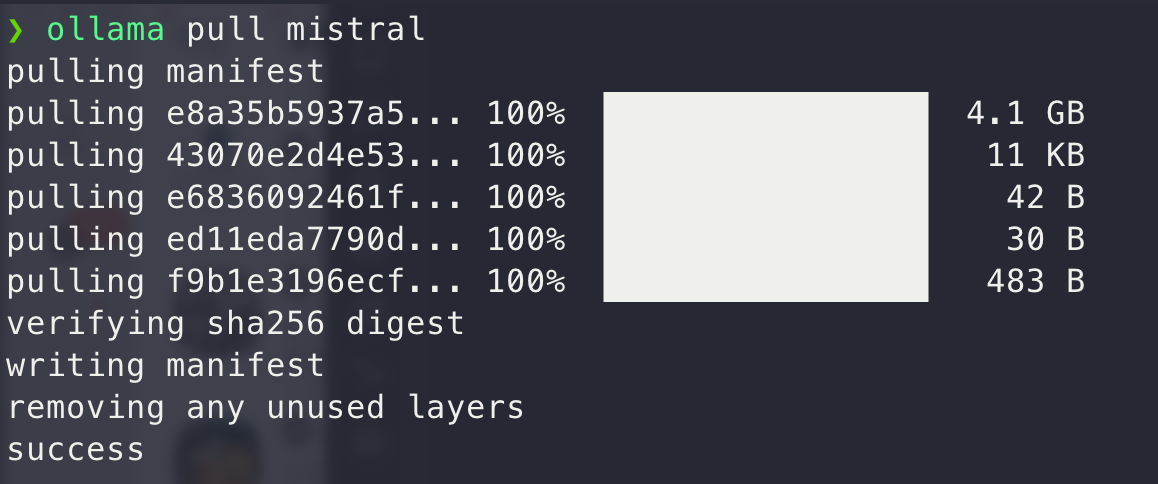

Ollama에서 Mistral AI 모델을 사용하려면, 먼저 모델을 다운로드해야 합니다. 다음 명령어를 통해 Mistral 모델을 다운로드할 수 있습니다:

ollama pull mistral: Mistral AI 모델 다운로드ollama list: PC에 설치된 AI 모델 확인

Ollama 사용 방법

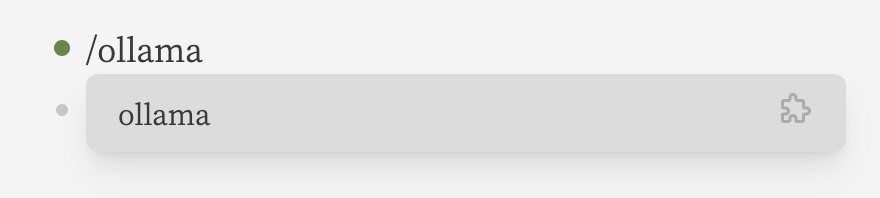

Logseq에서 Ollama를 활용하는 방법은 매우 간단합니다. 다음 두 가지 방법을 통해 Ollama를 호출할 수 있습니다:

- 1

/ollama명령어 사용: Logseq에서/ollama명령어를 입력하면 Ollama를 쉽게 호출할 수 있습니다.

- 단축키

Cmd+Shift+O사용: 이 단축키를 사용하여 ‘Ask ai’ 옵션을 선택하면 됩니다.

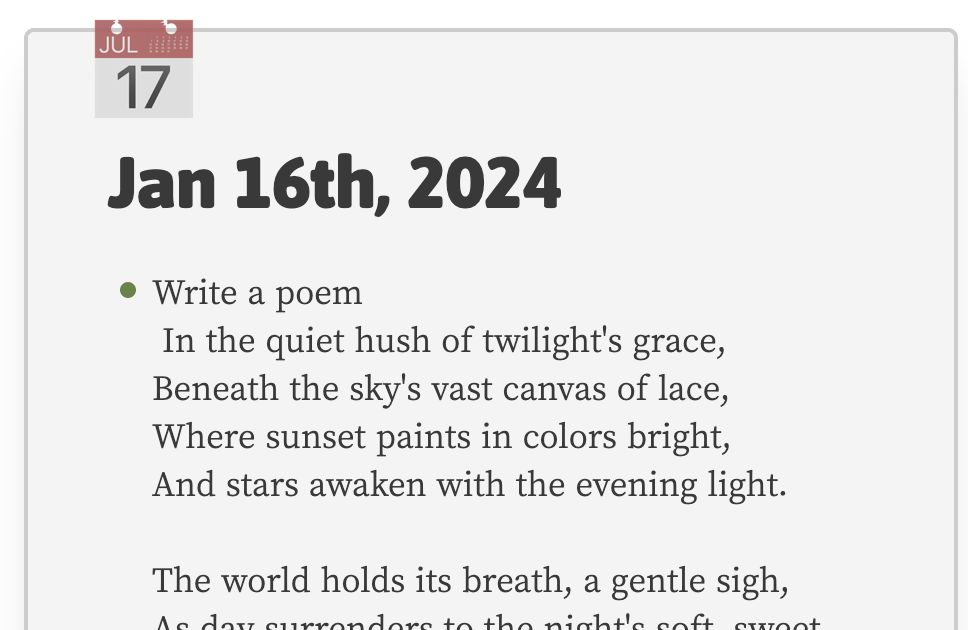

프롬프트를 입력창에 입력한 후 잠시 기다리면, AI가 제공하는 응답이 노트에 기록됩니다.

마치며

Ollama는 Logseq 사용자들에게 뛰어난 편의성과 생산성을 제공하는 도구입니다. 이 가이드를 통해 Ollama의 설치부터 활용 방법까지 이해하셨기를 바랍니다. 직접 경험을 통해 더 다양한 기능을 탐색하고, Logseq 환경에서의 작업 효율을 극대화해 보시길 권장드립니다. Ollama의 다양한 기능을 통해 작업을 보다 쉽고 효율적으로 수행할 수 있습니다.

or